背景 链接到标题

在平时会遇到不少系统崩溃之后文件系统异常的情况,通常我们会通过 fsck 工具进行修复,今天来了解下 fsck 做了什么,是怎么做的。

工作负载示例 链接到标题

假设现在存在一种工作负载,将单个数据块附加到原有文件。通过打开文件,调用 lseek() 将文件偏移量移动到文件末尾,然后在关闭文件之前,向文件发出单个 4KB 写入来完成追加。

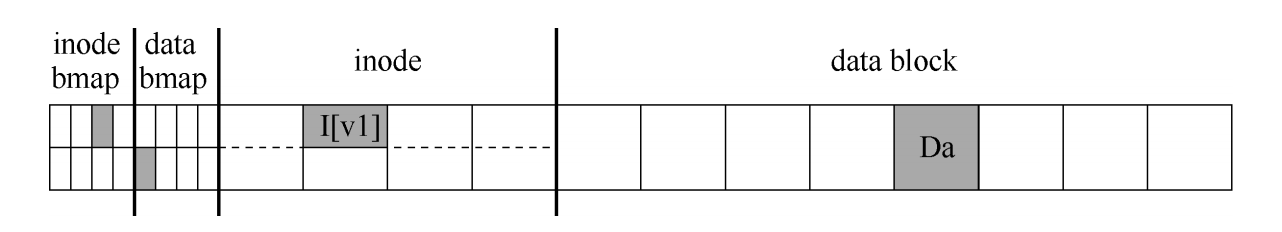

假定磁盘上使用标准的简单文件系统结构,包括一个 inode 位图(inode bitmap,只有 8 位,每个 inode 一个),一个数据位图(databitmap,也是 8 位,每个数据块一个),inode(总共 8 个,编号为 0 到 7,分布在 4 个块上),以及数据块(总共 8 个,编号为 0~7)。以下是该文件系统的示意图:

查看图中的结构,可以看到分配了一个 inode(inode 号为 2),它在 inode 位图中标记,单个分配的数据块(数据块 4)也在数据中标记位图。inode 表示为 I [v1],因为它是此 inode 的第一个版本。它将很快更新(由于上述工作负载)。再来看看这个简化的 inode。在 I[v1]中,可以看到:

owner : remzi

permissions : read-write

size : 1

pointer : 4

pointer : null

pointer : null

pointer : null

在这个简化的 inode 中,文件的大小为 1(它有一个块位于其中),第一个直接指针指向块 4(文件的第一个数据块,Da),并且所有其他 3 个直接指针都被设置为 null(表示它们未被使用)。当然,真正的 inode 有更多的字段。

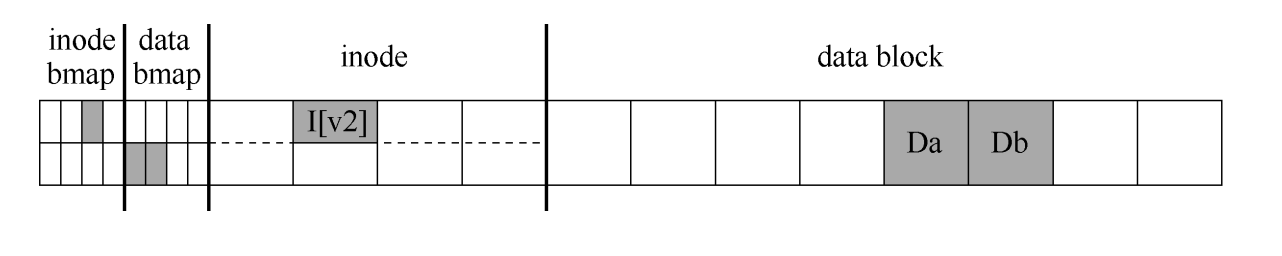

向文件追加内容时,要向它添加一个新数据块,因此必须更新 3 个磁盘上的结构:inode(必须指向新块,并且由于追加而具有更大的大小),新数据块 Db 和新版本的数据位图(称之为 B[v2])表示新数据块已被分配。 因此,在系统的内存中,有 3 个块必须写入磁盘。更新的 inode(inode 版本 2,或简称为 I [v2])现在看起来像这样:

owner : remzi

permissions : read-write

size : 2

pointer : 4

pointer : 5

pointer : null

pointer : null

更新的数据位图(B[v2])现在看起来像这样:00001100。最后,有数据块(Db),它只是用户放入文件的内容。希望文件系统的最终磁盘映像如下所示:

要实现这种转变,文件系统必须对磁盘执行 3 次单独写入,分别针对 inode(I[v2]),位图(B[v2])和数据块(Db)。请注意,当用户发出 write()系统调用时,这些写操作通常不会立即发生。脏的 inode、位图和新数据先在内存(页面缓存,page cache,或缓冲区缓存,buffer cache)中存在一段时间。

然后,当文件系统最终决定将它们写入磁盘时(比如说 5s 或 30s),文件系统将向磁盘发出必要的写入请求。遗憾的是,可能会发生崩溃,从而干扰磁盘的这些更新。特别是,如果这些写入中的一个或两个完成后发生崩溃,而不是全部 3 个,则文件系统可能处于异常的状态。

崩溃场景 链接到标题

想象一下,只有一次写入成功。因此有以下 3 种可能的结果:

- 只将数据块(Db)写入磁盘。在这种情况下,数据在磁盘上,但是没有指向它的 inode,也没有表示块已分配的位图。因此,就好像写入从未发生过一样。从文件系统崩溃一致性的角度来看,这种情况根本不是问题。

- 只有更新的 inode(I[v2])写入了磁盘。在这种情况下,inode 指向磁盘地址(5),其中 Db 即将写入,但 Db 尚未写入。因此,如果信任该指针,那将从磁盘读取垃圾数据(磁盘地址 5 的旧内容)。

此外,遇到了一个新问题,将它称为文件系统不一致(file-system inconsistency)。磁盘上的位图显示数据块 5 尚未分配,但是 inode 说它已经分配了。文件系统数据结构中的这种不同意见,是文件系统的数据结构不一致。要使用文件系统,必须以某种方式解决这个问题。

- 只有更新后的位图(B [v2])写入了磁盘。在这种情况下,位图指示已分配块 5,但没有指向它的 inode。因此文件系统再次不一致。如果不解决,这种写入将导致空间泄露(space leak),因为文件系统永远不会使用块 5。

在这个向磁盘写入 3 次的尝试中,还有 3 种崩溃场景。在这些情况下,两次写入成功,最后一次失败。

- inode(I[v2])和位图(B[v2])写入了磁盘,但没有写入数据(Db)。在这种情况下,文件系统元数据是完全一致的:inode 有一个指向块 5 的指针,位图指示 5 正在使用,因此从文件系统的元数据的角度来看,一切看起来都很正常。但是有一个问题:5 中又是垃圾。

- 写入了 inode(I[v2])和数据块(Db),但没有写入位图(B[v2])。在这种情况下,inode 指向了磁盘上的正确数据,但同样在 inode 和位图(B1)的旧版本之间存在不一致。因此,在使用文件系统之前,又需要解决问题。

- 写入了位图(B[v2])和数据块(Db),但没有写入 inode(I[v2])。在这种情况下,inode 和数据位图之间再次存在不一致。但是,即使写入块并且位图指示其使用,也不知道它属于哪个文件,因为没有 inode 指向该块。

从这些崩溃场景中可以看到由于崩溃而导致磁盘文件系统映像可能出现的许 多问题:在文件系统数据结构中可能存在不一致性。可能有空间泄露,可能将垃圾数据返回给用户,等等。

理想的做法是将文件系统从一个一致状态(在文件被追加之前),原子地 (atomically)移动到另一个状态(在 inode、位图和新数据块被写入磁盘之后)。遗憾的是,做到这一点不容易,因为磁盘一次只提交一次写入,而这些更新之间可能会发生崩溃或断电。将这个一般问题称为崩溃一致性问题(crash-consistency problem,也可以称为一致性更新问题,consistent-update problem)。

fsck 链接到标题

早期的文件系统采用了一种简单的方法来处理崩溃一致性。基本上,它们决定让不一致的事情发生,然后再修复它们(重启时)。这种偷懒方法的典型例子可以在一个工具中找到:fsck。fsck 是一个 UNIX 工具,用于查找这些不一致并修复它们。在不同的系统上,存在检查和修复磁盘分区的类似工具。请注意,这种方法无法解决所有问题。例如,考虑上面的情况,文件系统看起来是一致的,但是 inode 指向垃圾数据。唯一真正的目标,是确保文件系统元数据内部一致。

工具 fsck 在许多阶段运行,它在文件系统挂载并可用之前运行(fsck 假定在运行时没有其他文件系统活动正在进行)。一旦完成,磁盘上的文件系统应该是一致的,因此可以让用户访问。以下是 fsck 的基本总结:

- 超级块:fsck 首先检查超级块是否合理,主要是进行健全性检查,例如确保文件系统大小大于分配的块数。通常,这些健全性检查的目的是找到一个可疑的(冲突的)超级块。在这种情况下,系统(或管理员)可以决定使用超级块的备用副本。

- 空闲块:接下来,fsck 扫描 inode、间接块、双重间接块等,以了解当前在文件系统中分配的块。它利用这些知识生成正确版本的分配位图。因此,如果位图和 inode之间存在任何不一致,则通过信任 inode 内的信息来解决它。对所有 inode 执行相同类型的检查,确保所有看起来像在用的 inode,都在 inode 位图中有标记。

- inode 状态:检查每个 inode 是否存在损坏或其他问题。例如,fsck 确保每个分配的 inode 具有有效的类型字段(即常规文件、目录、符号链接等)。如果 inode 字段存在问题,不易修复,则 inode 被认为是可疑的,并被 fsck 清除,inode 位图相应地更新。

- inode 链接:fsck 还会验证每个已分配的 inode 的链接数。你可能还记得,链接计数表示包含此特定文件的引用(即链接)的不同目录的数量。为了验证链接计数,fsck 从根目录开始扫描整个目录树,并为文件系统中的每个文件和目录构建自己的链接计数。如果新计算的计数与 inode 中找到的计数不匹配,则必须采取纠正措施,通常是修复 inode 中的计数。如果发现已分配的 inode 但没有目录引用它,则会将其移动到 lost + found 目录。

- 重复:fsck 还检查重复指针,即两个不同的 inode 引用同一个块的情况。如果一个 inode 明显不好,可能会被清除。或者,可以复制指向的块,从而根据需要为每个 inode 提供其自己的副本。

- 坏块:在扫描所有指针列表时,还会检查坏块指针。如果指针显然指向超出其有效范围的某个指针,则该指针被认为是“坏的”,例如,它的地址指向大于分区大小的块。在这种情况下,fsck 不能做任何太智能的事情。它只是从 inode 或间接块中删除(清除)该指针。

- 目录检查:fsck 不了解用户文件的内容。但是,目录包含由文件系统本身创建的特定格式的信息。因此,fsck 对每个目录的内容执行额外的完整性检查,确保“.”和“..”是前面的条目,目录条目中引用的每个 inode 都已分配,并确保整个层次结构中没有目录的引用超过一次。

总结 链接到标题

如上所述,构建有效工作的 fsck 需要复杂的文件系统知识。确保这样的代码在所有情况下都能正常工作可能具有挑战性。然而,fsck(和类似的方法)有一个更大的、也许更根本的问题:它们太慢了。

对于非常大的磁盘卷,扫描整个磁盘,以查找所有已分配的块并读取整个目录树,可能需要几分钟或几小时。随着磁盘容量的增长和 RAID 的普及,fsck 的性能变得令人望而却步。在更高的层面上,fsck 的基本前提似乎有点不合理。考虑上面的示例,其中只有 3 个块写入磁盘。扫描整个磁盘,仅修复更新 3 个块期间出现的问题,这是非常昂贵的。

这种情况类似于将你的钥匙放在卧室的地板上,然后从地下室开始,搜遍每个房间,执行“搜索整个房子找钥匙”的恢复算法。它有效,但很浪费。